En apenas cinco años, la inteligencia artificial generativa ha pasado de ser una novedad y una línea de investigación prometedora a convertirse en una tecnología transversal que afecta a prácticamente todos los sectores. Modelos capaces de generar texto, imágenes, vídeo y audio a partir de un par de peticiones del usuario han irrumpido en procesos ya no solo metódicos, sino creativos. En la industria musical lo hemos visto desde la composición musical hasta la masterización inteligente.

Este desarrollo tan exponencial se puede relacionar con tres factores principales:

- Tecnología avanzada. Los modelos de lenguaje (LLMs) suponen una revolución técnica sin precedentes. Tal está siendo el avance, que ya se empieza a hablar de la “Quinta revolución industrial” 1.

- Accesibilidad. Con herramientas gratuitas o de bajo coste que permiten que cualquier persona pueda usar esta tecnología. No hace falta un conocimiento más especializado, como sí pasó con la introducción de los ordenadores personales. La adopción de la IA generativa de manera generalizada alcanzó un 39 % en solo dos años, mientras que internet tardó cinco años y los ordenadores personales casi 12 en alcanzar niveles comparables, como muestra la imagen publicada por The Visual Capitalist 2.

- Integración rápida. Una integración acelerada en plataformas de consumo masivo, desde la industria más técnica hasta las redes sociales y servicios de streaming.

ACT | The App Association. Antitrust at a Crossroads: Protecting Innovation in the AI Era.

La industria musical no ha sido la excepción aquí. La IA generativa ya no es solo un recurso para visualizar ideas creativas, sino que empieza a formar parte del ciclo económico de la música. Se hace notar en la propiedad intelectual y la remuneración, incluso en la relación con los fans y la propia identidad artística.

Estos cambios que casi se han impuesto al público han tenido consecuencias. Por ejemplo, un estudio de Deezer 3 revela que el 97% de los oyentes no es capaz de distinguir si una canción estaba generada con IA o no; y el 80% querría que las canciones generadas por IA estuviesen etiquetadas, de manera que pudiesen distinguirse de las creadas por artistas humanos y elegir si escucharlas o no en base a ello.

Sin embargo, no todas las opiniones son negativas. Por un lado, la IA es una gran herramienta creativa. Permite acelerar la composición, explorar estilos nuevos y hacer demos al momento.

Algunos músicos y teóricos musicales ya hablaban de la idea de un “instrumento algorítmico” que incluía la IA en 2019 4. Incluso instituciones culturales, como el British Arts & Humanities Research Council (AHRC) a través del novedoso programa BRAID 5 plantean la integración de la IA y el arte bajo un soporte institucional claro.

La mayoría de las opiniones a favor hablan de la IA como herramienta de apoyo, no como sustituta del músico. Esta idea se defiende muy bien en el artículo ‘Exploring the Needs of Practising Musicians in Co‑Creative AI Through Co‑Design’ publicado en 2025 6, en el que se trabajó con músicos en activo para identificar cómo usar IA generativa como herramienta co-creativa, generando variaciones musicales o acompañamientos. Este trabajo se realizó bajo un prisma de experimentación y con músicos a favor de su uso que la integraban en sus flujos habituales.

Pero, por otro lado, la IA también puede ser una amenaza. La cuestión no es solo si sustituirá al trabajo humano o si le resta valor, sino cómo ha sido entrenada. Cada semana aparece una nueva noticia hablando de cómo modelos actuales de IA Generativa han sido entrenados con contenidos no autorizados, incluyendo grabaciones de artistas, catálogos completos de discográficas, o voces de cantantes sin su consentimiento explícito. El propio Parlamento Europeo ha señalado este problema en un estudio exhaustivo sobre IA generativa y derechos de autor, destacando la falta de trazabilidad y la opacidad de los datasets 7.

Qué son los modelos fair-trained y por qué son relevantes

El término fair-trained model ha comenzado a ganar presencia en informes, debates legislativos y proyectos de la industria cultural. Aunque todavía está en construcción, puede definirse de forma operativa como un modelo de IA entrenado exclusivamente con datos obtenidos mediante consentimiento, licencias claras, compensación adecuada y mecanismos de trazabilidad verificables. Dicho de otro modo, un sistema cuyos datos de entrenamiento no se basan en una extracción indiscriminada de contenido disponible en Internet, sino en acuerdos explícitos con los titulares de los derechos.

La organización Fairly Trained 8, por ejemplo, propone un sistema de certificación para modelos cuya fase de entrenamiento se basa únicamente en obras propias, de dominio público o con licencia autorizada, siendo la mayor parte de los modelos de compañías certificadas relativos a la industria musical.

En paralelo, la Data Provenance Initiative (2023) ha demostrado que es técnicamente posible auditar masivamente datasets y clasificar su licenciamiento, lo que convierte la transparencia, antes considerada imposible, en un requisito razonable 9. A nivel más prospectivo, el proyecto DECORAIT propone un modelo de registro para que artistas y titulares de derechos puedan decidir si sus obras pueden usarse para entrenar IA 10.

Esta aproximación hacia los modelos fair-trained, contrasta con la práctica habitual de los últimos años, el open-web scraping. Los modelos más famosos y grandes que conocemos, como ChatGPT, Suno o Udio, han sido entrenados a través de una recolección masiva de contenidos disponibles en internet (textos, imágenes, voces, grabaciones musicales, interpretaciones en directo, stems de producción, etc.) sin preguntar a sus autores, sin informar a los intérpretes y sin establecer remuneración alguna. Estudios recientes estiman que los modelos más influyentes han sido entrenados con cientos de miles de horas de audio o millones de imágenes sin licencia 11.

La importancia de los modelos fair-trained no solo se muestra con el respeto a la autoría, sino que podría ayudar a crear un ecosistema económico sostenible que incluya a los modelos de inteligencia artificial dentro de las industrias, donde cada contribución al dataset puede reconocerse y compensarse, como sucede actualmente con licencias, repertorios y derechos de uso.

Frente a esta idea, algunos actores del sector de la IA han defendido que entrenar sobre todo Internet sería una extensión natural del derecho al acceso a la información. Sin embargo, voces críticas recuerdan que no existe un “derecho automático a entrenar”12, del mismo modo que tampoco existe un derecho automático a apropiarse del trabajo creativo ajeno bajo la excusa de la innovación tecnológica.

Ethical and bias considerations in artificial intelligence/machine learning 13

Dimensión técnica: ¿cómo se construye un modelo fair-trained?

Desde una perspectiva técnica, un modelo fair-trained suele construirse sobre tres pilares esenciales.

- Curación del dataset. Cada ítem del conjunto de datos, como una pista vocal, una interpretación instrumental, un archivo MIDI o una grabación de estudio, en el caso de modelos de audio, debe acompañarse de un registro de origen. Este registro debe incluir las licencias asociadas y condiciones de uso de la pieza concreta, como indican decenas de artículos 14 15. Esto incluye metadatos de autoría, fecha, derechos de uso y, cuando existen, acuerdos específicos con intérpretes.

- Exclusión y consentimiento. Un sistema responsable debe permitir que un artista pueda excluirse del entrenamiento o limitar el uso de sus obras a ciertos fines. Los estándares emergentes en la Unión Europea (especialmente a partir de la AI Act 16) incluyen obligaciones de documentar los datos utilizados, revelar la procedencia del corpus y ofrecer mecanismos efectivos de retirada u oposición cuando así lo solicite un creador o titular de derechos. Este principio está alineado con iniciativas técnicas ya mencionadas como DECORAIT 10, que propone sistemas verificables para registrar consentimiento mediante infraestructura descentralizada, y con los modelos de certificación voluntaria promovidos por organizaciones como la ya mencionada Fairly Trained.

- Alineamiento con principios éticos y auditoría. La fase de entrenamiento debe incorporar medidas técnicas para evitar que el modelo reproduzca obras concretas o estilos demasiado identificables. La literatura reciente identifica múltiples estrategias para mitigar la reconstrucción indebida. Algunos ejemplos son las técnicas de anti-memorization 17 18 o los sistemas de watermarking inverso 19, para garantizar que un modelo no pueda replicar grabaciones originales. El objetivo aquí no es limitar la creatividad del modelo, sino evitar la explotación directa de obras protegidas y asegurar un uso justo, documentado y éticamente compatible del material artístico.

Dimensión ética: preservar el valor intrínseco del trabajo creativo en la era algorítmica

Las artes y en especial la música han sido históricamente profesiones donde gran parte del valor aportado no es visible a ojos del público: horas de estudio, entrenamiento, trabajo emocional, desgaste físico, etc. Como señala Pettinger (2015) 20, el trabajo artístico está atravesado por formas de “valor encubierto” que rara vez se remuneran adecuadamente. Cuando un modelo entrenado sin consentimiento se apropia de una técnica desarrollada corporalmente, la explotación no es solo económica, es corpórea y simbólica, en el sentido de que convierte habilidades humanas no cuantitativas en estadísticas sin reconocimiento ni crédito.

La literatura crítica insiste en que los datasets masivos no son neutrales ni inocuos. Birhane (2021) mostró que los grandes datasets están llenos de sesgos y estereotipos racistas, sexistas, etc 21.

Por otro lado, Crawford, en su libro Atlas of AI: Power, politics, and the planetary costs of artificial intelligence (2021) argumenta que la IA funciona como una forma contemporánea de extracción de recursos, incluidos recursos culturales, donde el trabajo humano se absorbe bajo la etiqueta de “datos” 22.

Atlas of AI: Power, politics, and the planetary costs of artificial intelligence. 22

Este problema adquiere una dimensión especial en música, donde el entrenamiento indiscriminado puede borrar la autoría y convertir las voces e instrumentos de los intérpretes en material bruto del modelo. ¿Quién aparece acreditado cuando el sistema genera una canción al estilo de un intérprete?

En este contexto, la ética del fair-training no se reduce a pagar licencias, sino que exige reconocer que el trabajo creativo tiene un valor intrínseco y que ese valor debe preservarse en la era algorítmica. Como advierte la UNESCO (2023) 23, los sistemas de IA generativa deben situarse en un marco de derechos culturales y respeto a los creadores, no en una lógica de extracción ilimitada de datos.

Dimensión legal: fair-training como obligación

En Estados Unidos, de donde han salido las mayores compañías de IA generativa, este debate suele aparecer junto al término fair use. El fair use aparece como una excepción del derecho de autor recogida en la sección 107 del Copyright Act 24, que permite ciertos usos no autorizados de obras protegidas con fines de crítica, docencia, investigación, etc. Aunque esto solo aplica si, al evaluar estos cuatro factores, el uso puede considerarse legítimo:

- El propósito y el carácter del uso (incluida su naturaleza comercial y su grado de transformación).

- La naturaleza de la obra original.

- La cantidad del fragmento utilizado.

- El efecto del uso sobre el mercado potencial o el valor de la obra.

Sin embargo, la mayoría de análisis jurídicos subrayan que este marco no puede interpretarse como una carta blanca para el open-web scraping. Por ejemplo, Celeste Shen (2024) 25, muestra cómo muchos sistemas se entrenan con grandes volúmenes de obras con copyright sin consentimiento ni compensación, y argumenta que el fair use no elimina la necesidad de licencias allí donde el uso perjudica los intereses económicos de los autores.

La respuesta en muchos casos, ha sido recurrir a precedentes como el de Authors Guild v. Google (2015). En aquel caso, Google digitalizó libros para crear un índice buscable que mostraba solo fragmentos mínimos y no competía con el mercado de las obras originales, por lo que el tribunal consideró el uso como transformativo y amparado por fair use. Samuelson explica que los modelos de IA son muy distintos, absorben patrones expresivos y pueden generar obras completas que sustituyen música, texto o imágenes humanas, además de entrenarse sobre datasets opacos 26.

Siguiendo este pensamiento, en 2022, los abogados Matthew Butterick y Joseph Saveri se unieron para comenzar litigaciones contra compañías tan grandes como OpenAI, Meta o Nvidia. Todas ellas por violar derechos de autor en la creación de sus IAs. La información sobre los casos la mantienen actualizada en su web.

Por otro lado, en Europa, contamos con dos piezas clave para esta regulación, la Directiva de Derechos de Autor en el Mercado Único Digital (2019, conocida como DSM 27) y el Reglamento de Inteligencia Artificial (2024, conocido como AI Act), en fase de implementación todavía.

La DSM ha introducido excepciones específicas para la minería de datos, permitiendo la extracción de información de obras protegidas sólo bajo ciertas condiciones, como la investigación científica no comercial. Pero, aunque se cumplan esas condiciones, los titulares de los datos pueden excluirse si lo informan claramente. Es decir, en la UE, si un creador decide excluir sus obras del entrenamiento, las compañías de IA estarían obligadas a respetarlo 27.

El nuevo AI Act exige que los proveedores de modelos mantengan una documentación completa y rastreable de los datos de entrenamiento. Además, los desarrolladores deben ofrecer “resúmenes suficientemente detallados” de las obras protegidas utilizadas, así como demostrar que han adquirido licencias cuando correspondía. De este modo, el sistema europeo se orienta hacia un modelo donde el fair-training no es una elección moral o comercial, sino una obligación legal 16.

Dimensión económica: ¿hacia un mercado global de datasets de entrenamiento?

Hasta ahora, el entrenamiento masivo de modelos generativos ha funcionado, en la práctica, bajo un principio de externalidad negativa donde los artistas cuyos datos fueron usados no reciben compensación alguna, ni siquiera cuando las obras generadas por IA compiten directamente con su trabajo.

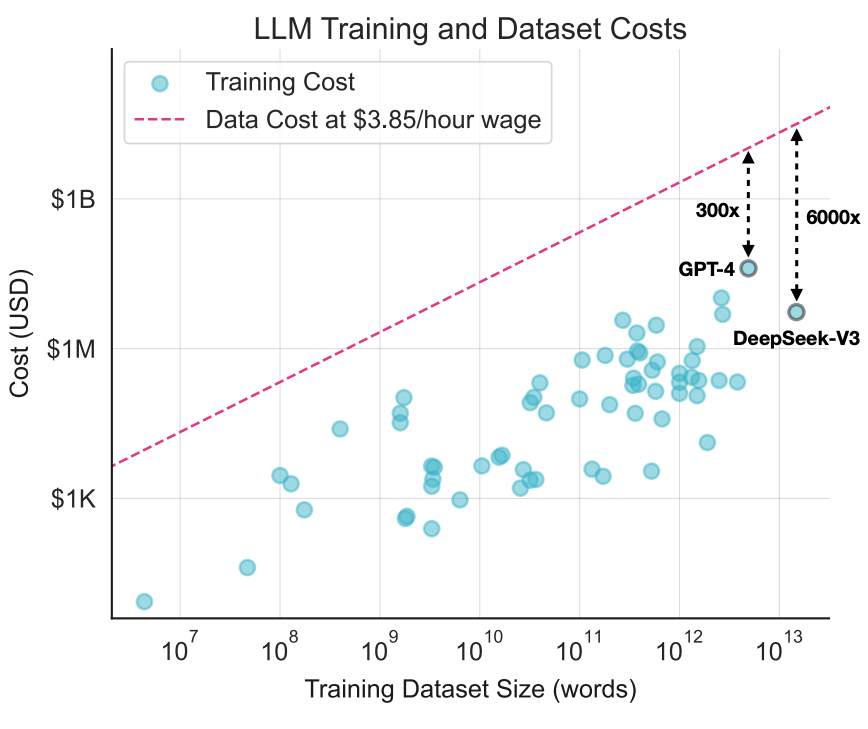

En este aspecto, es importante recordar la obviedad de que la creatividad no es un recurso ilimitado ni gratuito. Es el resultado de inversiones continuas en formación, infraestructura y tiempo. En este aspecto, el reciente estudio Position: The Most Expensive Part of an LLM should be its Training Data 28, estudió el coste que supondría generar los datasets de varios LLMs de manera justa, y concluye que la cifra estaría entre diez y mil veces el valor del propio entrenamiento que se hace sobre los datos.

Fairshare Data Pricing for Large Language Models 28

Este coste sería inabarcable para las empresas que generan los LLM, lo que aumenta el debate coste-beneficio-ética. En este aspecto, otros autores opinan que los precios de los datos justos son demasiado altos y que la solución sería llegar a un punto medio, de manera que fuesen costes asumibles para la empresa, pero también revertiesen un beneficio económico para el autor, según su importancia en el modelo 29.

Algunos autores van todavía más lejos y llegan a proponer la economía de los datos como una disciplina nueva, como Oderinwale y Kazlauskas, (2025), que analizan en su trabajo los acuerdos comerciales de datos entre 2020 y 2025 y resaltan cómo estos siguen siendo los activos económicos más menospreciados de la IA 30.

Respaldando el hecho de que son un bien económico muy importante, se ha estimado que el tamaño del mercado global de datasets de entrenamiento tendría un valor de unos 3.200 millones de dólares en 2024, ascendiendo hasta 16.000 millones en una década 31.

Hablando de números, usar datos protegidos sin permiso puede acabar resultando muy caro para las empresas. Por ejemplo, Anthropic, dueña del LLM Claude, acordó pagar 1.500 millones de dólares para resolver una demanda colectiva de autores y editoriales que la acusaban de descargar y almacenar alrededor de 500.000 libros sin permiso, siendo la mayor recuperación por copyright de la historia, con un pago de unos 3.000 dólares por libro a un fondo de compensación para titulares de derechos 32.

En el ámbito musical, la situación no es mejor. En 2023, un grupo de grandes discográficas (Universal, Concord, ABKCO, entre otras) demandó a Anthropic por el uso de letras protegidas para entrenar sus modelos, reclamando 75 millones de dólares en daños y apuntando a la posibilidad de exigir hasta 150.000 dólares por obra infringida 33. Otro caso más reciente es el de la RIAA contra Suno, donde se alega que la compañía habría obtenido canciones de YouTube para entrenar sus modelos generativos. En la demanda, la RIAA solicita 2.500 dólares por cada acto de elusión de medidas técnicas y hasta 150.000 dólares por cada grabación protegida usada sin autorización 34.

Estos son unos pocos ejemplos, pero cada semana aparecen más, y, aunque muchos de estos casos aún no se han traducido en cifras finales de indemnización, sí obligan a las empresas a destinar recursos a equipos legales y peritajes. Y, a menudo, a negociar acuerdos de licencia posteriores para poder seguir operando.

Modelos fair-trained: hacia una IA que conviva con los creadores

La inteligencia artificial generativa ha transformado la creación cultural con una velocidad sin precedentes, revelando tanto un enorme potencial como nuevas tensiones éticas, legales y económicas. Especialmente, destacamos el problema de que muchos modelos se entrenaron con obras ajenas sin permiso ni reconocimiento.

Es en este contexto en el que aparecen los modelos fair-trained. Su propuesta es clara: si la IA aprende de trabajo humano, ese trabajo debe ser visible, rastreable y, cuando corresponda, compensado.

Este enfoque no es solo una cuestión legal o técnica. En el mundo de la cultura, entrenar modelos con datos no autorizados implica borrar el esfuerzo de los autores. Por ello, la discusión se ha desplazado hacia la transparencia y el consentimiento, y empieza a formalizarse como certificaciones y nueva legislación.

Los modelos fair-trained no solucionan todas las tensiones entre tecnología y cultura, pero ofrecen una dirección más equilibrada, una IA que pueda convivir con los creadores sin apropiarse de su trabajo

- Medikepura, A. (2025, 13 de enero). Technology convergence is leading the way for the fifth industrial revolution. World Economic Forum. Accesible en este enlace. ↩︎

- ACT | The App Association. (2025, June 12). Antitrust at a Crossroads: Protecting Innovation in the AI Era. ACT. Accesible en este enlace. ↩︎

- Howarth, E. (2025, 12 de noviembre). New Deezer survey reveals public calls for transparency in AI-Generated music. Accesible en este enlace. ↩︎

- Magnusson, T. (2019). Sonic writing: Technologies of material, symbolic, and signal inscriptions. Bloomsbury Academic. ↩︎

- BRAID UK. Bridging responsible AI divides. Accesible en este enlace. ↩︎

- Krol, S. J., Llano Rodríguez, M. T., & Loor Paredes, M. (2025). Exploring the needs of practising musicians in co-creative AI through co-design. arXiv. Accesible en este enlace. ↩︎

- Lucchi, N. (2025). Generative AI and Copyright: Training, Creation, Regulation (PE 774.095). Parlamento Europeo. Accesible en este enlace. ↩︎

- Fairly Trained. Accesible en este enlace. ↩︎

- Longpre, S., Mahari, R., Chen, A., Obeng-Marnu, N., Sileo, D., Brannon, W., & Muennighoff, N. (2025). A large-scale audit of dataset licensing and attribution in AI. Nature Machine Intelligence. Accesible en este enlace. ↩︎

- Balan, K., Gilbert, A., Black, A., Jenni, S., Parsons, A., & Collomosse, J. (2023). DECORAIT – DECentralized Opt-in/out Registry for AI Training. Proceedings of the European Conference on Visual Media Production (CVMP ’23). Association for Computing Machinery. Accesible en este enlace. ↩︎

- Carlini, N., Hayes, J., Nasr, M., Jagielski, M., Sehwag, V., Tramèr, F., Balle, B., Ippolito, D., & Wallace, E. (2023). Extracting Training Data from Diffusion Models. En Proceedings of the 32nd USENIX Security Symposium. Accesible en este enlace. ↩︎

- The Trichordist. (2025, 5 de noviembre). There Is No ‘Right to Train’: How AI Labs Are Trying to Manufacture a Safe Harbor for Theft. Accesible en este enlace ↩︎

- Hanna, M. G., Pantanowitz, L., Jackson, B., Palmer, O., Visweswaran, S., Pantanowitz, J., Deebajah, M., & Rashidi, H. H. (2025). Ethical and bias considerations in artificial intelligence/machine learning. Modern Pathology, 38(3), 100686. Accesible en este enlace. ↩︎

- Bender, E. M., & Friedman, B. (2018). Data Statements for Natural Language Processing: Toward Mitigating System Bias and Enabling Better Science. Transactions of the Association for Computational Linguistics, 6, 587–604. Accesible en este enlace. ↩︎

- Gebru, T., Morgenstern, J., Vecchione, B., Wortman Vaughan, J., Wallach, H., Daumé III, H., & Crawford, K. (2021). Datasheets for Datasets. Communications of the ACM, 64(12), 86–92. Accesible en este enlace. ↩︎

- AI Act (Reglamento 2024/1689). European Union. (2024). Regulation (EU) 2024/1689 of the European Parliament and of the Council of 13 June 2024 laying down harmonised rules on Artificial Intelligence (AI Act). Official Journal of the European Union, L , 12 July 2024.. Accesible en este enlace. ↩︎

- Bossy, T., Vignoud, J., Rabbani, T., Troncoso Pastoriza, J. R., & Jaggi, M. (2025). Mitigating unintended memorization with LoRA in federated learning for LLMs. Accesible en este enlace. ↩︎

- Carlini, N., Liu, C., Ú. Erlingsson, Kos, J., & Song, D. (2019). The Secret Sharer: Evaluating and Testing Unintended Memorization in Neural Networks. En 28th USENIX Security Symposium (USENIX Security ’19). Accesible en este enlace. ↩︎

- Epple, P., Shilov, I., Stevanoski, B., & de Montjoye, Y.-A. (2024). Watermarking training data of music generation models. Accesible en este enlace. ↩︎

- Pettinger, L. (2015). On emotional labour: Embodied labour in music work. The British Journal of Sociology, 66(2), 282–300. Accesible en este enlace. ↩︎

- Birhane, A., & Prabhu, V. U. (2021). Large image datasets: A pyrrhic win for computer vision? In Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision (WACV 2021) (pp. 1537–1547). IEEE. Accesible en este enlace. ↩︎

- Crawford, K. (2021). Atlas of AI: Power, politics, and the planetary costs of artificial intelligence. Yale University Press. ↩︎

- UNESCO. (2023). Guidance for generative AI in education and research. Accesible en este enlace. ↩︎

- United States Code. 17 U.S.C. § 107: Limitations on exclusive rights: Fair use. Accesible en este enlace. ↩︎

- Celeste Shen, Fair Use, Licensing, and Authors’ Rights in the Age of Generative AI, 22 NW. J. TECH. & INTELL. PROP. 157 (2024). Accesible en este enlace. ↩︎

- Samuelson, P. (2023). Generative AI Meets Copyright. Silicon Flatirons. Accesible en este enlace. ↩︎

- Directiva DSM (2019/790). European Union. (2019). Directive (EU) 2019/790 of the European Parliament and of the Council of 17 April 2019 on copyright and related rights in the Digital Single Market and amending Directives 96/9/EC and 2001/29/EC. Official Journal of the European Union, L 130, 92–125. Accesible en este enlace. ↩︎

- Kandpal, N., & Raffel, C. (2025). Position: The most expensive part of an LLM should be its training data. Accesible en este enlace. ↩︎

- Zhang, L., Jiao, C., Li, B., & Xiong, C. (2025). Fairshare Data Pricing for Large Language Models. Accesible en este enlace. ↩︎

- Oderinwale, H., & Kazlauskas, A. (2025). The Economics of AI Training Data: A Research Agenda. Accesible en este enlace. ↩︎

- Global Market Insights. (2025). AI Training Dataset Market Size & Share, Forecasts Report 2034. Accesible en este enlace. ↩︎

- Brittain, B., & Scarcella, M. (2025, septiembre 5). Anthropic agrees to pay $1.5 billion to settle author class action. Reuters. Accesible en este enlace. ↩︎

- Luckey, B. (2023, octubre 19). Major Music Publishers Sue Anthropic Over AI-Generated Lyrics for $75M. Law Commentary. Accesible en este enlace. ↩︎

- Brittain, B., & Scarcella, M. (2025, September 22). Record labels claim AI generator Suno illegally ripped their songs from YouTube to train its generative-music models. The Verge. Accesible en este enlace. ↩︎