La evolución de la inteligencia artificial musical no es una simple mejora lineal, sino un cambio de paradigma que ha provocado una tensión entre el control explícito y la capacidad de generación. El debate sobre la opacidad en este dominio, al igual que en la síntesis de voz, se esclarece al diferenciar entre los modelos regresivos o simbólicos (la “IA tradicional”) y los modelos generativos (la IA generativa moderna, basada en deep learning).

El análisis de esta opacidad se debe centrar no en una explicación causal de cada microparámetro, sino en identificar dónde se sitúa el umbral de explicabilidad que aporta valor técnico y permite una auditoría rigurosa.

A continuación, analizamos los fundamentos técnicos de cada tipo de IA, su evolución histórica, diferencias en el resultado sonoro y ejemplos representativos de herramientas en cada categoría.

Modelos regresivos: máxima explicabilidad

Los modelos regresivos o simbólicos representan el enfoque tradicional de la composición asistida por IA. Su fundamento y transparencia técnica reside en que operan de forma exclusiva en el dominio simbólico (partituras o MIDI), tratando la música como una secuencia de elementos discretos. Los mecanismos de estos sistemas son fundamentalmente autoregresivos, prediciendo el siguiente evento dado el historial y la aplicación de reglas.

Históricamente, esto incluye algoritmos basados en reglas explícitas (como las empleadas por Experiments in Musical Intelligence – EMI), modelos estadísticos (cadenas de Markov con restricciones) o arquitecturas tempranas de Redes Neuronales Recurrentes (RNN) como LSTM o GRU.

Esta capa operativa ofrece la máxima transparencia para quien audita: un sistema basado en reglas es inherentemente interpretable, lo que permite rastrear la causa específica de cada nota, acorde o evento hasta la regla predefinida o la probabilidad estadística que lo generó. En esencia, son sistemas que admiten un ajuste manual y son directamente auditables.

En términos de implicaciones operacionales y de sonido, el enfoque simbólico prioriza el control explícito y la predictibilidad sobre la capacidad de síntesis compleja. Permiten al usuario o desarrollador asegurar una estructura formal correcta sin desviaciones inesperadas (por ejemplo, garantizando las secciones de un rondó o la progresión armónica de un blues de 12 compases).

Sin embargo, esta limitación se manifiesta en el resultado sonoro: la música generada tiende a ser correctamente estructurada y sólida desde una perspectiva teórica (buena armonía y ritmo), pero dado que su salida es solo una partitura digital, puede sonar mecánica, rígida o sintetizada si no se interpreta con sintetizadores avanzados. La falta de sutileza tímbrica y expresiva que se genera al manipular waveforms o audio real limita su aplicación en la generación de música de alta fidelidad que se perciba como humana.

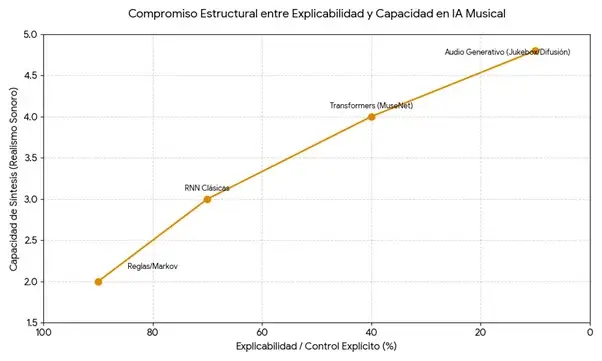

Compromiso estructural entre explicabilidad y capacidad en IA musical. La curva ilustra el intercambio fundamental entre la transparencia y el rendimiento: los modelos regresivos (Reglas/Markov) ofrecen control explícito y máxima explicabilidad, mientras que los modelos generativos avanzados (Jukebox/Difusión) alcanzan el mayor realismo sonoro a costa de la opacidad inherente a sus arquitecturas distribuidas.

Modelos generativos modernos: riqueza sonora, pero con opacidad

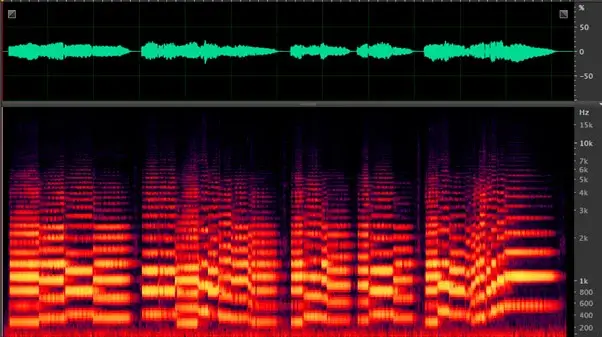

A diferencia de la IA musical tradicional, que trabaja exclusivamente con representaciones simbólicas como notas, duraciones o acordes en formato MIDI o partitura, los modelos generativos modernos operan directamente sobre el sonido. Estos utilizan espectrogramas, codificaciones latentes de audio o incluso la propia onda sonora como entrada y salida del sistema. Esto les permite aprender no solo qué notas se tocan, sino cómo suenan: timbre, expresividad, articulación, textura…

Gracias a ello, pueden generar música con matices interpretativos y timbres realistas, incluyendo simulaciones de voz humana o producción de estudio. En términos prácticos, la IA tradicional compone como un escritor de partituras y la generativa moderna como un productor que trabaja directamente con el sonido.

Diagrama de onda (arriba) y espectro de una señal armónica. Las frecuencias se muestran en orden ascendente en el eje vertical y el tiempo en el horizontal. La intensidad del color aumenta con la densidad.

Fuente: Albertcastan – Trabajo propio, CC BY-SA 4.0, https://commons.wikimedia.org/w/index.php?curid=37028434

Este cambio de enfoque requiere técnicas de aprendizaje profundo y se basa en la capacidad de los modelos generativos modernos para aprender y reproducir las distribuciones de probabilidad que subyacen en grandes datasets musicales.

El fundamento y opacidad estructural de estos sistemas reside en su capacidad para operar en el dominio subsimbólico, manejando pesos numéricos, waveforms o tokens de audio, en lugar de notas discretas. Los mecanismos clave incluyen arquitecturas avanzadas como los Transformers (con el mecanismo de autoatención visible en MuseNet o Music Transformer), VAEs (MusicVAE), modelos de difusión (MusicLM, MusicGen) y arquitecturas híbridas complejas (OpenAI Jukebox).

La opacidad estructural es una consecuencia directa de este diseño de deep learning: dado que son sistemas distribuidos, la funcionalidad reside en patrones colectivos de activación, lo que hace inviable trazar una causa única y local para cada elemento generado en la salida. Este salto cualitativo en realismo y expresividad se consigue sacrificando la interpretabilidad local por la complejidad de las representaciones internas.

Estrategias de auditoría en modelos generativos

Pese a esta opacidad inherente a su arquitectura, se puede alcanzar un control efectivo sobre el sistema si centramos la auditoría en sus capas externas, como los datos de entrenamiento y la trazabilidad de la salida. Las estrategias de transparencia operacional se concentran en dos vectores principales: los datos de entrenamiento y la inferencia de outputs.

Respecto a los datos, la opacidad no es una limitación técnica (ya que herramientas como el audio fingerprinting permiten auditar el contenido), sino que es a menudo una decisión deliberada de los desarrolladores.

La auditoría de la fase de inferencia y salida exige garantizar la trazabilidad operacional y la reproducibilidad del proceso. Esto se logra mediante el registro exhaustivo de variables operacionales, como las semillas aleatorias, la versión precisa del modelo y las condiciones exactas de entrada utilizadas para producir una pieza. Además, el watermarking técnico, que inserta marcadores imperceptibles en el audio generado, permite identificar de manera fehaciente el modelo y el timestamp de su creación.

| Capa de transparencia | Modelos generativos (aplicación) | Función de auditoría |

| 1. Datos de entrenamiento | Grandes datasets (ej. 1,2M de canciones para OpenAI Jukebox) | La auditabilidad de los datos es técnicamente trivial. La tecnología de audio fingerprinting y los pipelines automatizados son plenamente operativos. Estos sistemas pueden comparar millones de archivos de audio con bases de datos de referencia en minutos, permitiendo verificar si el dataset contiene material específico con precisión forense. Por lo tanto, si la información sobre el contenido del dataset no se revela, la opacidad es una decisión consciente (deliberada) y no una limitación tecnológica. |

| 2. Inferencia de outputs | Generación de audio completo (ej. OpenAI Jukebox) | La trazabilidad operacional y la reproducibilidad del proceso de generación se aseguran mediante el registro de variables clave (semillas aleatorias, versiones del modelo y condiciones de entrada). Este protocolo se refuerza con el watermarking técnico, una técnica que inserta marcadores imperceptibles en el audio para identificar de manera fehaciente tanto el modelo de origen como el momento exacto (timestamp) de la generación. |

El compromiso entre explicabilidad y capacidad en IA musical

El panorama de la IA musical está definido por un intercambio entre explicabilidad y capacidad (que exploramos más en profundidad en este artículo[1] ).Este equilibrio sigue una frontera de Pareto, donde el aumento en complejidad y capacidad de síntesis (como en WaveNet y modelos difusivos) conlleva una drástica disminución de la transparencia.

Por un lado, la IA regresiva o simbólica aporta control, solidez teórica y explicabilidad, aunque dentro de límites estilísticos marcados, generando música que puede resultar basada en fórmulas o predecible. Por el otro, la IA generativa ofrece una mayor riqueza y variedad, captura matices sutiles y tiene la capacidad de fundir estilos distintos, pero a costa de ser opaca y, ocasionalmente, errática.

La solución pragmática a esta dicotomía no reside en buscar la transparencia absoluta del modelo, sino en establecer el concepto de opacidad gestionable.

La atención se traslada del desafío de conocimiento inherente a la arquitectura (el intento de comprender el funcionamiento interno de la red) a la fiscalización de la información que se oculta intencionadamente (el problema deliberado), exigiendo la transparencia y auditoría en las capas externas del sistema, especialmente en los datasets de entrenamiento y la trazabilidad de la inferencia.

La tendencia actual apunta, por lo tanto, a la convergencia mediante sistemas neurosimbólicos que aprovechan el conocimiento musical explícito y las redes entrenadas, buscando así lo mejor de ambos enfoques.