Cuando hablamos de transparencia en IA musical, a menudo confundimos tres problemas distintos bajo una misma etiqueta.

El primero es de conocimiento: no sabemos cómo funcionan internamente ciertos modelos. Incluso con acceso completo a pesos y arquitectura, las redes profundas son sistemas distribuidos sin componentes interpretables uno a uno. Entendemos la matemática, pero no podemos trazar causas locales claras para cada decisión del modelo. Esto está bien documentado en literatura de interpretabilidad.

El segundo es metodológico: no tenemos herramientas adecuadas para inspeccionarlos. Tenemos muchas herramientas (saliency, attribution, probing, attention analysis…), pero ninguna ofrece una explicación completa o fiable en todos los casos.

El campo de interpretabilidad progresa, pero no resuelve el problema de fondo: la estructura de los modelos no está diseñada para ser transparente. Por tanto, es correcto decir que las herramientas son insuficientes a la hora de dar una explicación exhaustiva.

El tercero es deliberado: alguien decide no revelar información que sí podría documentarse. Muchas empresas que entrenan estos modelos no documentan los datasets; se ocultan pesos, arquitecturas concretas, parámetros de entrenamiento, criterios de curación de datos, metadatos o pipelines.

En el contexto de la IA musical, esta distinción es crucial. La cuestión importante no es si podemos desentrañar cada microinteracción dentro de una red neuronal de 175 mil millones de parámetros, un ejercicio que se acerca más a lo filosófico que a lo práctico, sino definir dónde situamos el umbral de explicabilidad que realmente aporta valor técnico. Y, sobre todo, identificar qué capas del sistema permiten una auditoría rigurosa sin necesidad de acceder al código fuente.

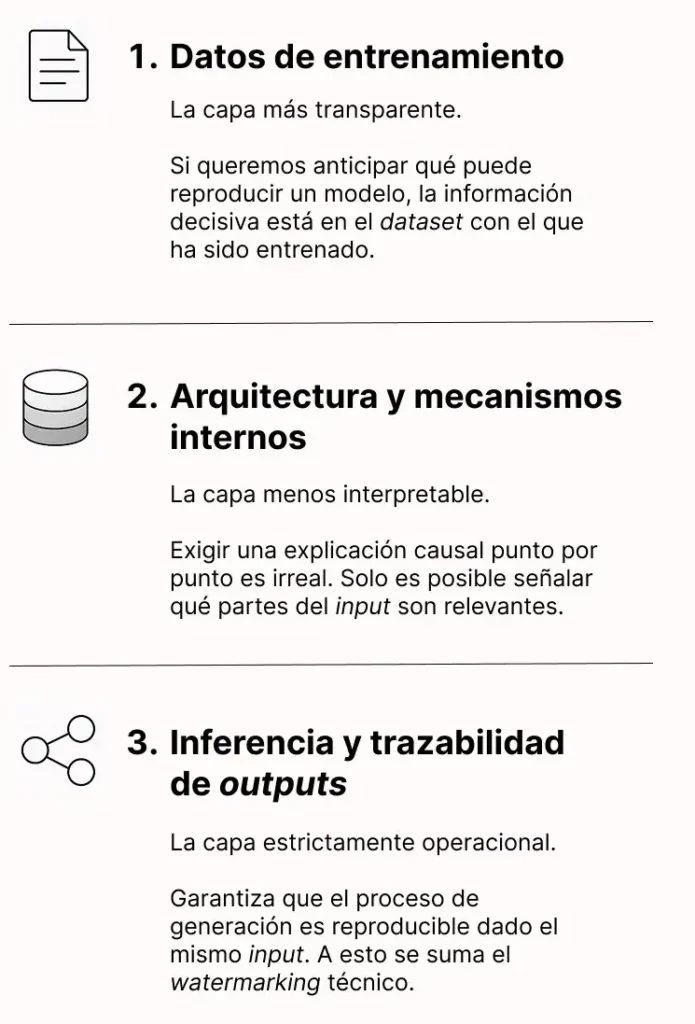

Los 3 niveles de transparencia en IA musical: datos, arquitectura e inferencia

Todo sistema de IA musical opera en tres niveles superpuestos, cada uno con su propio grado de transparencia posible:

- Datos de entrenamiento

Esta es la capa más transparente, o al menos debería serlo. Un modelo aprende únicamente de aquello que estuvo presente durante su entrenamiento. Si queremos anticipar qué puede reproducir, clonar o sintetizar, la información decisiva no está en los pesos del modelo, sino en el dataset con el que ha sido entrenado.

La tecnología para auditar grandes corpus de audio existe desde hace años y es plenamente operativa. El audio fingerprinting, la misma técnica que permite a Shazam identificar canciones o a las plataformas de streaming gestionar royalties, puede comparar millones de archivos con bases de datos de referencia en cuestión de minutos. Los sistemas avanzados generan representaciones tiempo-frecuencia-energía, extraen eventos acústicos robustos frente a degradaciones (ruido, compresión,pitch shifting) y los indexan para búsquedas a gran escala.

Aplicado a la certificación de modelos, esto significa que resulta técnicamente trivial comprobar si un dataset contiene material concreto. No se trata de revisar pistas una por una, sino de ejecutar pipelines automatizados capaces de procesar terabytes de audio y devolver coincidencias con precisión forense. En esta capa, la opacidad no proviene de limitaciones técnicas, sino de una decisión consciente de no revelar información.

- Arquitectura y mecanismos internos

En esta capa la transparencia se vuelve mucho más difícil. Los modelos de última generación en síntesis de voz (WaveNet, Tacotron, modelos difusivos) funcionan con arquitecturas profundas que transforman representaciones de muy alta dimensión dentro de espacios latentes complejos. Cada capa aplica operaciones no lineales que, combinadas, producen el resultado final.

¿Podemos “explicar” por qué un modelo genera exactamente esa frecuencia fundamental en un frame concreto? En rigor, no. Las redes neuronales profundas son sistemas distribuidos: la información no reside en neuronas aisladas con funciones claras, sino en patrones colectivos de activación. Exigir una explicación causal punto por punto es tan irreal como pedir a un físico que describa la trayectoria individual de cada molécula en un gas: posible en teoría, inútil en la práctica.

Aun así, existen niveles intermedios de interpretabilidad que sí aportan información relevante:

- Análisis de atención: En modelos basados en Transformers, permite ver qué partes del input influyen más en cada decisión del modelo. Por ejemplo, qué fonemas pesan más en la generación de un timbre concreto.

- Saliency maps y activaciones: Técnicas como Grad-CAM o LIME identifican qué regiones del espectrograma de entrada son más determinantes para el resultado. No ofrecen la causa última, pero sí señalan dónde se concentra la información relevante.

- Pruebas de interpolación: Explorar el espacio latente permite comprobar si el modelo memoriza ejemplos específicos o aprende representaciones generales. Si pequeños cambios en el vector latente provocan saltos bruscos hacia voces presentes en el training set, es una señal clara de overfitting.

- Inferencia y trazabilidad de outputs

Esta tercera capa es estrictamente operacional: se trata de determinar si podemos reconstruir cómo se generó un output concreto. Para ello es necesario registrar hiperparámetros, semillas aleatorias, versiones del modelo y todas las condiciones de entrada.

En entornos de producción, los sistemas bien diseñados mantienen registros completos que garantizan reproducibilidad: dado el mismo input y los mismos parámetros, el modelo debe producir exactamente el mismo resultado. No aporta transparencia sobre el funcionamiento interno del modelo, pero sí sobre el proceso de generación, y eso es crucial para depuración, auditorías y verificaciones.

A esto se suma el watermarking técnico: la inserción de marcadores imperceptibles en el audio generado que permiten identificar el modelo utilizado, su versión e incluso el timestamp de generación. Existen técnicas basadas en espectro y en fase capaces de resistir compresiones, cambios de formato e incluso regrabaciones acústicas.

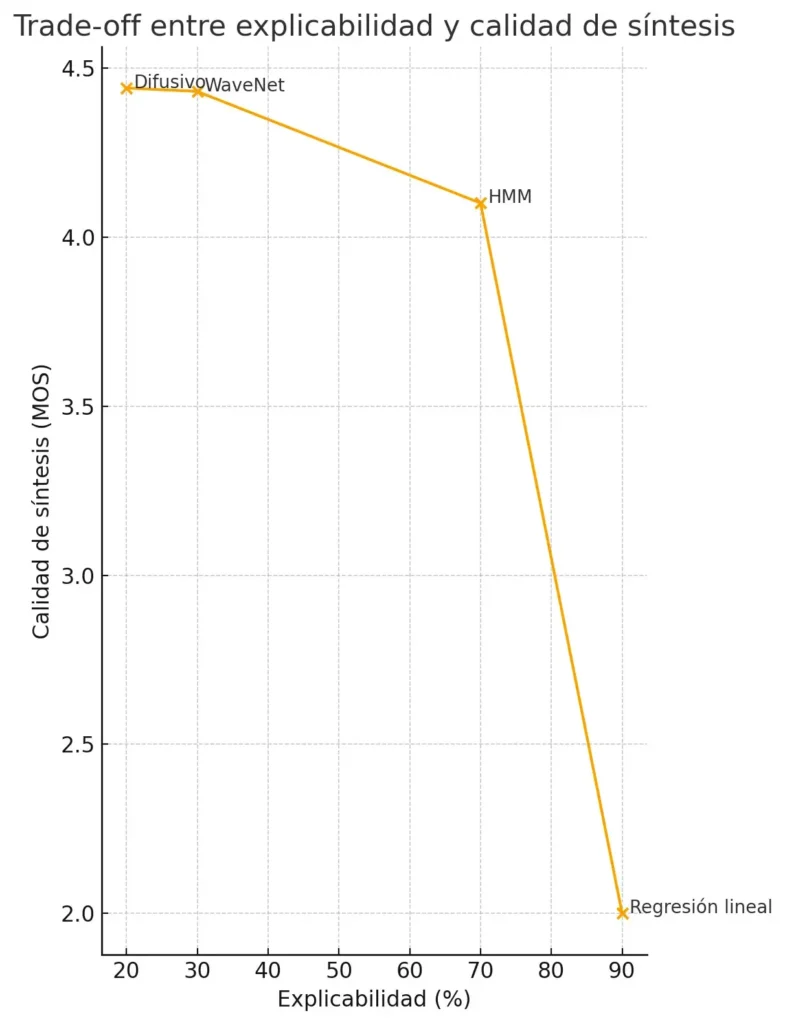

El trade-off inevitable: ¿por qué mayor calidad significa menos transparencia?»

La tensión entre rendimiento y transparencia no es casual; forma parte de la propia estructura de estos sistemas. Los modelos que resultan más interpretables (como los árboles de decisión, las regresiones lineales o los enfoques basados en reglas) se quedan cortos cuando se aplican a tareas complejas como la síntesis de audio de alta fidelidad.

El salto de calidad que ha experimentado, por ejemplo, el clonado de voces en los últimos cinco años, pasando de sistemas concatenativos a modelos neuronales end-to-end, tiene su origen precisamente en la adopción de arquitecturas profundas. Estas arquitecturas renuncian a la interpretabilidad local en favor de representaciones más ricas, jerárquicas y expresivas, capaces de capturar matices que los modelos transparentes simplemente no pueden modelar.

La explicación de por qué los modelos con más capacidades son tan opacos es fundamentalmente matemática. Las redes profundas aprenden representaciones distribuidas en las que cada rasgo emergente depende de interacciones complejas entre múltiples capas.

En WaveNet, por ejemplo, las convoluciones dilatadas permiten que la red tenga en cuenta sonidos que están muy cerca entre sí y otros que ocurrieron mucho antes, sin necesidad de hacer el modelo demasiado grande. El filtro se “estira” dejando huecos entre las muestras que analiza, y así puede captar tanto detalles finos como patrones más amplios. Por eso no existe una “neurona de la F0” ni una “capa del timbre”: esas características no viven en un sitio concreto, sino que surgen de muchos patrones de activación que trabajan en conjunto.

Esta forma de representar la información tiene implicaciones técnicas claras:

- Generalización frente a memorización: En modelos profundos, cierta opacidad es aceptable si va acompañada de una buena capacidad de generalización. Voice-Swap, por ejemplo, se entrena con improvisaciones vocales, no con canciones completas, para que el sistema aprenda el “aparato vocal” (formantes, articulación, dinámica de pitch) en lugar de memorizar líneas melódicas. La clave es poder verificar que el dataset no incluye material problemático: si los datos son limpios, la opacidad funcional del modelo deja de ser un riesgo.

- Precisión en casos límite: Los modelos interpretables suelen rendir bien en voces “promedio”, pero fallan cuando aparecen características poco comunes: afonía, susurros, técnicas extendidas. Las redes profundas, en cambio, capturan esa variabilidad con mucha más fidelidad, aunque no podamos desglosar exactamente cómo lo hacen.

- Coste computacional de la explicabilidad: Generar saliency maps, entrenar modelos auxiliares para interpretar decisiones (como LIME) o realizar análisis de sensibilidad exhaustivos multiplica el coste computacional por factores de 10 o incluso 100. En producción, estos métodos pueden resultar directamente inviables.

Estrategias prácticas para gestionar la transparencia en IA musical

Si la transparencia absoluta no es alcanzable, la pregunta relevante es “¿qué mecanismos sí permiten un control riguroso sobre los sistemas?”.

- Auditoría de datasets como proxy: Verificar a fondo los datos de entrenamiento reduce de forma decisiva la incertidumbre sobre lo que el modelo es capaz de generar. En clonado de voces, por ejemplo, un sistema entrenado únicamente con grabaciones limpias de locutores contratados no puede, por construcción, reproducir voces que nunca hayan sido parte del dataset.

- Protocolos de testing estandarizados: Cuando no es posible explicar el modelo por dentro, podemos caracterizarlo por fuera. Baterías de pruebas que evalúan si replica ejemplos del entrenamiento, si mantiene diversidad en sus outputs o si resiste inputs adversariales permiten establecer su comportamiento real. No revelan el “cómo”, pero sí delimitan el “qué”.

- Modelos de caja blanca como referencia: En aplicaciones críticas, mantener modelos transparentes, como HMMs o sistemas paramétricos, sirve como línea base. Si el modelo opaco produce resultados que la versión interpretable no podría generar usando el mismo dataset, es señal de que están apareciendo capacidades no triviales que requieren atención adicional.

- Arquitecturas modulares: Dividir el sistema en etapas auditables mejora la trazabilidad y el control. Separar la extracción de features acústicos, el modelado prosódico y la síntesis de forma de onda permite revisar cada módulo por separado y verificar las interfaces entre ellos, en lugar de depender de un modelo end-to-end completamente opaco.

Hacia una transparencia gestionable: puntos de control clave para IA musical

La «caja negra» de la IA musical no es monolítica. Existen capas donde la transparencia es técnicamente factible y debe exigirse (datos), otras donde solo podemos aspirar a una interpretabilidad parcial (arquitectura) y algunas donde basta con la trazabilidad operacional (inferencia).

El enfoque pragmático no busca cristalizar cada parámetro del modelo, sino establecer puntos de control auditables en las etapas críticas. La tecnología existe: fingerprinting robusto, herramientas de interpretabilidad, protocolos de testing. La pregunta ya no es si podemos abrir la caja, sino si estamos dispuestos a invertir en los mecanismos técnicos que lo hagan posible de forma sistemática.

Gráfica — Trade-off entre explicabilidad y calidad de síntesis en distintas arquitecturas de generación de audio.

La gráfica muestra cómo a medida que aumentan la complejidad y la capacidad de los modelos (WaveNet y modelos difusivos), la explicabilidad disminuye drásticamente mientras que la calidad de síntesis (MOS) mejora. Los modelos paramétricos clásicos como los HMM ocupan una posición intermedia: menos precisos que los modelos profundos pero todavía interpretables. La regresión lineal aparece como un extremo puramente pedagógico: máxima explicabilidad, mínima capacidad. La línea dibuja una frontera de Pareto conceptual, que ilustra que no es posible mejorar simultáneamente explicabilidad y calidad más allá de ciertos límites.